Um projeto do Actions empacota todas as ações em um único contêiner. Você publicar este projeto no Actions on Google para que o Google Assistente saiba como descobrir e invoque suas experiências de conversa.

Você usa os seguintes componentes de baixo nível para criar seu projeto do Actions:

Configurações e recursos definem os metadados do projeto. e recursos como ícones de projeto. O Google usa essas informações para publicar suas ações ao diretório do Assistente, para que os usuários possam descobrir e invocar para resolvê-los com rapidez.

Intents representam uma tarefa a ser realizada, como entrada do usuário ou um evento do sistema que precisa de processamento. O tipo mais comum de que você usará são as intents do usuário. Essas intents permitem que você declare o treinamento frases que são naturalmente expandidas pelo processamento de linguagem natural (PLN) mecanismo para incluir muitas outras frases parecidas. O PLN usa a agregação essas frases para treinar um modelo de linguagem que o Google Assistente usa para corresponder entrada. Durante uma conversa, se alguma entrada do usuário corresponder ao idioma da intent o ambiente de execução do Google Assistente envia a intent à ação para que ela possa processá-los e responder ao usuário.

Com os tipos, você pode extrair dados estruturados da entrada do usuário. De anotando frases de treinamento com tipos, o PLN extrai dados relevantes e você não precisa analisar entradas abertas.

Scenes processam intents e são os principais executores lógicos de suas ações. Eles podem preencher o slot, avaliar a lógica condicional, solicitações ao usuário e até mesmo chamar serviços da Web externos para realizar lógica de negócios. Em combinação com intents, as cenas oferecem uma maneira poderosa de detectar entradas específicas do usuário ou eventos do sistema e realizar as ações lógica.

Os comandos definem as respostas estáticas ou dinâmicas que você usa para responder aos usuários.

Os Webhooks permitem delegar trabalho extra a serviços da Web. (fulfillment), como validar dados ou gerar comandos. Suas ações se comunicar com o fulfillment usando um protocolo de webhook baseado em JSON.

Com a Tela interativa, você cria imagens e experiências imersivas com aplicativos da web que utilizam HTML, CSS e JavaScript.

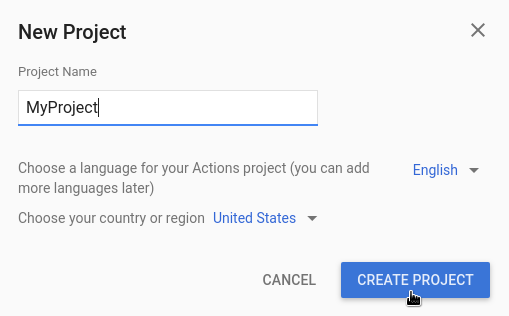

Criar um projeto

Você precisa criar um projeto no Console do Actions antes de desenvolver para Google Assistente Para criar um projeto:

- Acesse o Console do Actions.

- Clique em Novo projeto.

- Digite um nome para o projeto e clique em Criar projeto.

- Na tela Que tipo de ação você quer criar?, selecione a categoria que melhor representa seu projeto e clique em Próxima.

- Na tela Como você quer criar, selecione uma forma de criar e clique em Começar a criar. Por exemplo, é possível começar com uma ou com uma amostra.

Definir as informações do projeto

As configurações e os recursos do seu projeto definem as informações dele, como suporte a recursos e plataformas, localidades aceitas, nome de exibição, descrição, logotipos e muito mais. A tabela a seguir descreve as principais configurações e recursos que você fornecer. Esse recurso é usado pelo Actions on Google para implantar e publicar seu projeto no Assistente diretório atual.

| Nome | Descrição |

|---|---|

| Informações do diretório | Fornece informações para que o Actions on Google possa publicar seus projeto para o diretório do Assistente. Inclui metadados e descrições sobre seu projeto e recursos de imagem para logotipos e imagens de banner. |

| Segmentação por local | Configura as localidades em que suas ações estão disponíveis. |

| Recursos da plataforma | Configura as plataformas em que suas ações estão disponíveis. |

| Detalhes da empresa | Especifica os dados de contato da sua empresa. |

| Verificação de marca | Conecte um site ou app Android de sua propriedade para ter mais benefícios como nomes de invocação reservados e vinculação de sites nas suas ações. |

| Versão | Configura diferentes versões de teste e produção para sua ação para testes e produção. |

| Links do Google Assistente | Permita que os usuários invoquem suas ações nas propriedades da Web. |

Para definir as informações do projeto:

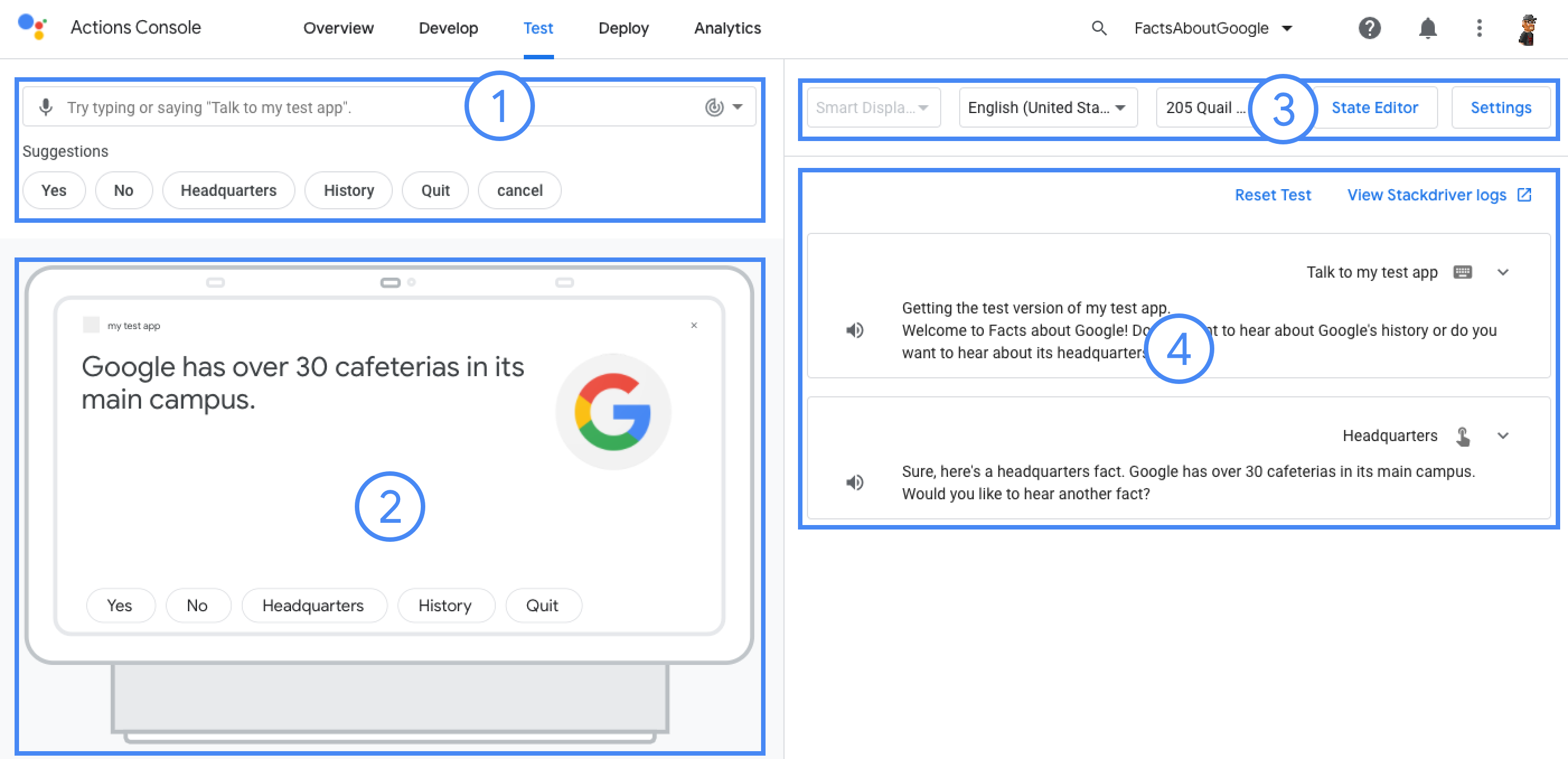

Testar projetos no simulador

O Console do Actions oferece um simulador para visualização das suas ações. A permite que você veja informações de depuração, defina recursos do dispositivo, simule localidade e muito mais.

Para testar um projeto: