本文专门在差分隐私环境中总结了设备端个性化 (ODP) 的隐私保护方法。为了重点介绍本文档,我们特意忽略了其他隐私隐患和设计决策(例如数据最小化)。

差分隐私

差分隐私1是统计数据分析和机器学习中广泛采用的隐私保护标准2 3。通俗地说,无论对手的记录是否出现在底层数据集中,对手都可以从差分隐私算法的输出中了解到几乎相同的用户信息。这意味着要为个人提供强有力的保护:关于某个人的任何推断都只能取决于数据集的汇总属性,无论是否有该人的记录。

在机器学习的语境中,算法的输出应被视为经过训练的模型参数。短语几乎相同由两个参数(该类 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料 资料, 该类 中的 景观 通常选为小常数 资料的资料) 进行量化, 以及 ➘≪1/(用户数量)。

隐私语义

ODP 设计旨在确保每次训练运行都是 (该广告系列) 的用户级差分隐私。下文概述了我们实现这种语义的方法。

威胁模型

我们定义了不同方,以及关于每个方的状态假设:

- 用户:拥有设备且使用开发者所提供产品或服务的用户。他们的隐私信息完全可供他们自己查看。

- 可信执行环境 (TEE):TEE 内发生的数据和可信计算可防范使用各种技术的攻击者。因此,计算和数据不需要额外的保护。现有 TEE 可能允许其项目管理员访问其中的信息。我们推荐了一些自定义功能,用于禁止并验证管理员无法访问相应访问权限。

- 攻击者:可能有关于用户的辅助信息,并且拥有对离开 TEE 的所有信息的完整访问权限(例如已发布的模型参数)。

- 开发者:定义和训练模型的人。被视为不可信(且拥有攻击者的全部能力)。

我们力求设计具有以下差分隐私语义的 ODP:

- 信任边界:从用户的角度来看,信任边界由用户自己的设备以及 TEE 组成。离开此信任边界的任何信息都应受差分隐私保护。

- 攻击者:相对于攻击者的全面差分隐私保护。信任边界以外的任何实体都可能是攻击者(其中包括开发者和其他用户,所有这些实体都有可能互相冲突)。考虑到信任边界以外的所有信息(例如已发布的模型)、有关用户的任何辅助信息以及无限资源,攻击者无法推断出有关用户的其他私密数据(除了辅助信息中已有的数据),达到隐私预算指定的可能性。 具体而言,这意味着相对于开发者而言,这可提供全面的差分隐私保护。发布给开发者的任何信息(例如经过训练的模型参数或汇总推断)均受差分隐私保护。

本地模型参数

之前的隐私语义可以应对某些模型参数是设备本地参数的情况(例如,模型包含每个用户特有的用户嵌入,并且不在用户之间共享)。对于此类模型,这些本地参数保留在信任边界内(无法发布),不需要保护,而共享模型参数则会发布(受差分隐私保护)。这有时也称为广告牌隐私模型 4。

公开功能

在某些应用中,部分功能是公开的。例如,在电影推荐问题中,电影的特征(电影的导演、类型或发行年份)是公开信息,不需要保护,而与用户相关的特征(例如受众特征信息或用户观看过的电影)是隐私数据,需要保护。

公开信息正式化为公开特征矩阵(在前面的示例中,该矩阵将每行电影包含一行,每个电影特征一列),可供所有各方使用。差分隐私训练算法可以利用该矩阵而无需保护,请参见示例 5。ODP 平台计划实现此类算法。

在预测或推理过程中保护隐私的方法

推理基于模型参数和输入特征。模型参数使用差分隐私语义进行训练。这里讨论的是输入特征的作用。

在某些用例中,如果开发者已经拥有对推理中使用的特征的完全访问权限,那么推断就不存在隐私问题,并且推断结果可能会对开发者可见。

在其他情况下(如果推理中使用的特征是不公开的,开发者无法访问),开发者可能会隐藏推理结果,例如,通过在设备端、操作系统拥有的进程和显示区域中运行推理(以及使用该推理结果的任何下游进程),在该进程之外进行受限的通信。

训练过程

概览

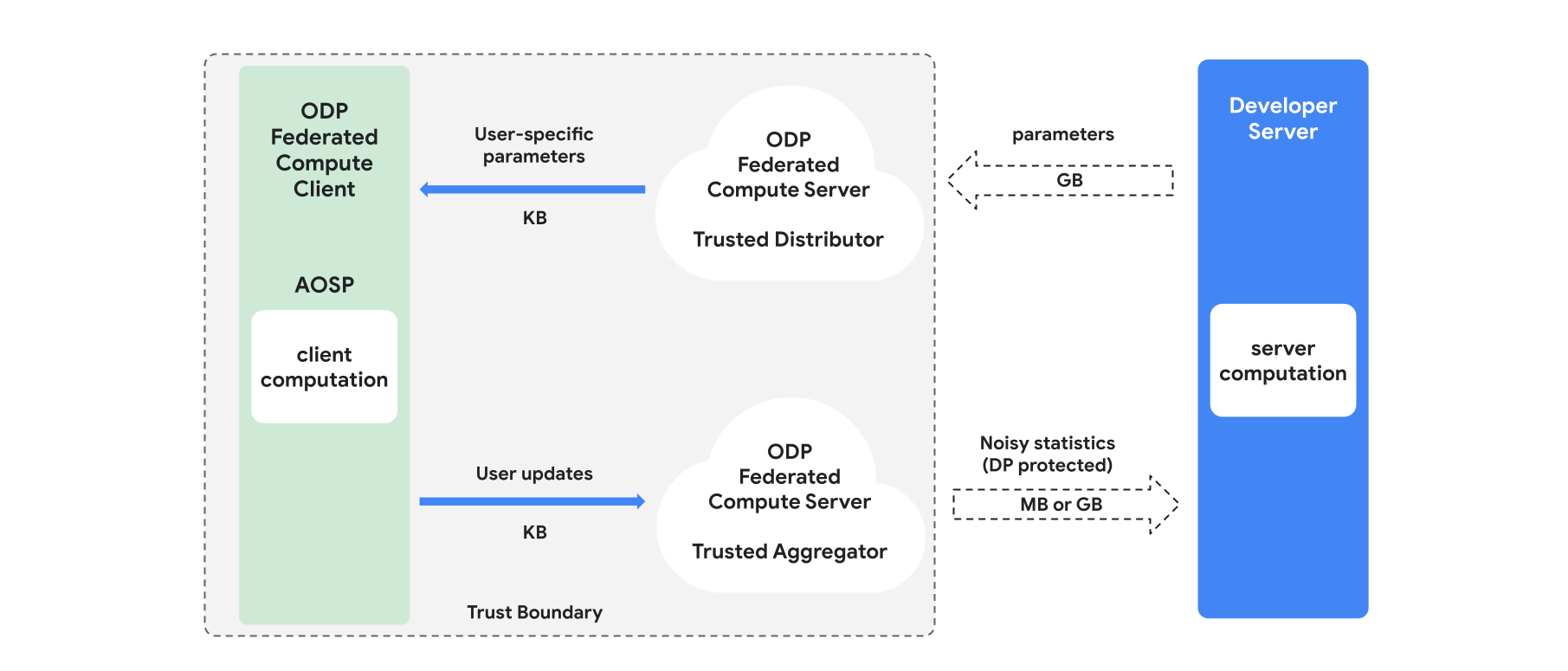

本部分概述了此架构以及训练的后续流程,如图 1 所示。 ODP 实现了以下组件:

可信分发服务器,例如联合选择、可信下载或私密信息检索,起到广播模型参数的作用。假定可信的分销商可以向每个客户发送一部分参数,而不会透露哪个客户端下载了哪些参数。这种“部分广播”可让系统尽可能减少对最终用户设备的影响:系统并不会发送模型的完整副本,而是只会将一部分模型参数发送给任何指定用户。

可信的聚合器会聚合来自多个客户端的信息(例如梯度或其他统计信息),然后添加噪声并将结果发送到服务器。这种假设是假设客户和集合商家之间,以及客户和分销商之间都有可信的渠道。

在该基础架构上运行的 DP 训练算法。每种训练算法都包含在不同组件(服务器、客户端、聚合器、分销商)上运行的不同计算。

一轮典型的训练包括以下步骤:

- 服务器向可信的分销商广播模型参数。

- 客户端计算

- 每台客户端设备都会接收广播模型(或与用户相关的参数子集)。

- 每个客户端都会执行一些计算(例如计算梯度或其他足够的统计)。

- 每个客户端将计算结果发送到可信的集合商家。

- 受信任的聚合器会使用适当的差分隐私机制收集、汇总和保护来自客户端的统计信息,然后将结果发送到服务器。

- 服务器计算

- (不可信)服务器对受差分隐私保护的统计信息运行计算(例如,使用差分隐私汇总梯度来更新模型参数)。

分解模型和差分隐私交替最小化

ODP 平台计划提供可应用于任何模型架构(如 DP-SGD6 7 8 或 DP-FTRL 9 10)的通用差分隐私训练算法,以及专用于分解模型的算法。

分解模型是指可以分解为子模型(称为编码器或塔)的模型。例如,假设一个格式为 f(u(θu, xu), v(θv, xv)) 的模型,其中 u() 对用户特征 xu 进行编码(具有参数 θu),v() 对非用户特征 xv(且具有参数 θv)进行编码。使用 f() 组合这两种编码,以生成最终的模型预测。例如,在电影推荐模型中,xu 是用户特征,xv 是电影特征。

此类模型非常适合上述分布式系统架构(因为它们可以将用户特征和非用户特征分开)。

将使用差分隐私交替最小化 (DPAM) 训练分解模型,它会在优化参数 θu(当 θv 固定)之间交替进行,反之亦然。事实证明,DPAM 算法在各种设置中都可以实现更好的效用 4 11,尤其是在存在公开功能的情况下。

参考

- 1:Dwork 等人在 TCC'06 中校准隐私数据分析中的噪声灵敏度

- 2:美国人口普查局。Understanding Differential Privacy(了解差分隐私),2020 年

- 3:《Federated Learning with Form Differential Privacy Guarantees》(采用正式差分隐私保证的联邦学习),Google AI 博文,2020 年

- 4:Jain 等,差异化隐私模型个性化,NeurIPS'21

- 5:Krichene 等人,《Private Learning with Public Features》,2023 年

- 6:Song et al. Stochastic gradient descent with differentally private updates(使用差分隐私更新实现随机梯度下降法),GlobalSIP'13

- 7:FOCS'14 的差分隐私经验风险最小化:高效算法和严格错误边界

- 8:Abadi 等人. Deep Learning with Differential Privacy(CCS '16)

- 9:Smith et al. (Nearly) Optimal Algorithms for Private Online Learning in Full-information and Bandit Settings, NeurIPS'13

- 10:Kairouz 等,Practical and Private (Deep) Learning without Sampling or Shuffling,ICML'21

- 11:Chien 等人的私人交替最小二乘法,ICML'21